di Mattia Chiaruttini

Apple negli ultimi anni ha basato la propria strategia commerciale sulla privacy. Sull’onda degli scandali che hanno coinvolto i suoi competitor, in particolare Facebook, l’azienda di Cupertino ha deciso dapprima di promuovere la messaggistica crittografata, poi ha introdotto un’importante novità dando la possibilità agli utenti di decidere se approvare o meno il tracciamento da parte delle app ai fini di marketing (dando fastidio per l’appunto a tutte le aziende che investono in sponsorizzate su Facebook).

https://youtu.be/8w4qPUSG17Y

Giovedì scorso, per un obiettivo sicuramente condivisibile, Apple ha annunciato di voler combattere gli abusi sessuali sui minori e, per farlo, introdurrà una serie di aggiornamenti tecnici che stanno facendo già discutere.

Dai prossimi sistemi operativi rilasciati da Apple in autunno (iOS15), e solamente per gli USA (se l’esperimento andrà bene, verrà estero a tutto il mondo), saranno attive delle misure che permetteranno di scansione le foto archiviate su iPhone e iCloud alla ricerca di immagini di abusi sui minori. Da un lato, questo sistema potrebbe aiutare le forze dell’ordine nelle indagini, dall’altro potrebbe aprire le porte a maggiori richieste legali e governative per i dati degli utenti.

Sicurezza bambini: le misure di Apple

Ci sono tre misure principali che Apple utilizzerà per perseguire il suo obiettivo:

- la modifica riguardante l’app di ricerca di Apple e Siri. Qualora un utente ricercasse argomenti relativi all’abuso sessuale su minori, verrà messo in guardia da Apple e indirizzato a delle risorse per chiedere aiuto. E fin qui, niente di strano;

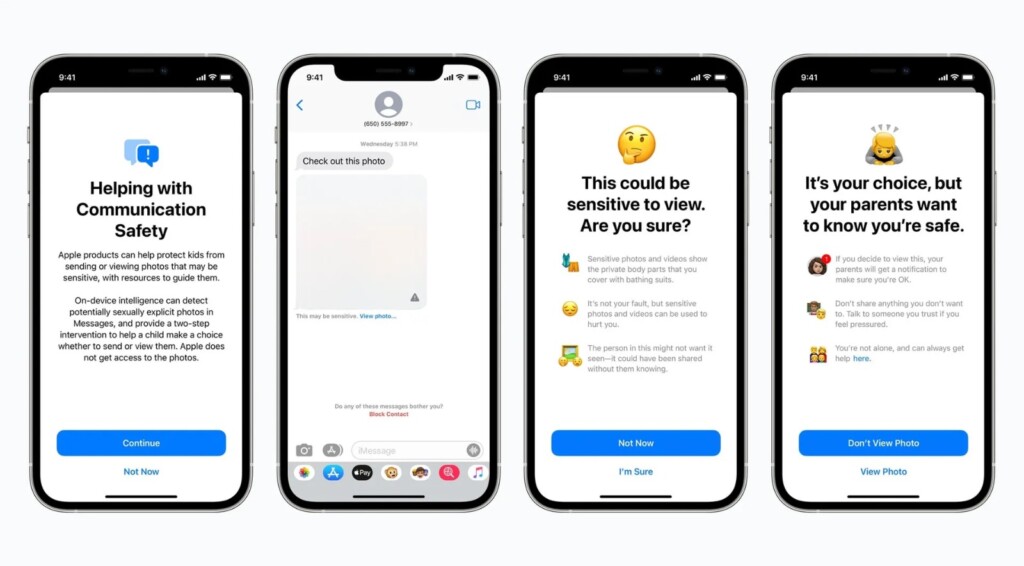

- communication safety in iMessage, sui dispositivi dei minori. Cosa comporterà? Questo sistema, che non è attivo di default, analizzerà le foto che vengono scambiate tra gli utenti su iMessage nei dispositivi dei minori. Se verranno trovate delle fotografie esplicite, il sistema le oscurerà inviando una notifica ai genitori che hanno abilitato il Parental Control.

- CSAM (Child Sexual Abuse Material): si occuperà di trovare, all’interno di iCloud Photo, delle immagini già note che derivano da abusi su minori. Cosa significa “già note”? Vuol dire che c’è già un database con tutte le immagini pedopornografiche (lo gestisce una non-profit finanziata dal governo statunitense) e Apple, tramite il sistema che ha sviluppato chiamato NeuralHash andrà ad analizzare le fotografie che abbiamo sul nostro cloud e se il sistema dovesse rilevare qualcosa di sospetto, e superata una certa soglia di segnalazioni, verrà inviata una segnalazione ad Apple. Delle persone poi, manualmente, verificheranno caso per caso la situazione e le foto “incriminate” e potranno a loro volta contattare le forze dell’ordine;