Attorno all’anno 1450 il tedesco Johannes Gutenberg inventa per il mondo occidentale la stampa a caratteri mobili, dando il via ad una nuova epoca nello sviluppo della comunicazione umana.

Il 13 ottobre 1994 Marc Andreessen progetta e realizza Mosaic/Netscape, il primo browser web, dando il via ad un processo di democratizzazione nella distribuzione delle news che destabilizza l’industria dell’editoria. Ma permette anche la nascita di Amazon, Facebook, Wikipedia e in definitiva tutto ciò che caratterizza il nostro vivere moderno.

L’ora di ChatGPT

Il 30 novembre 2022 OpenAI (società originariamente creata da Elon Musk e Sam Altman) apre a tutti ChatGPT (Chat Generative Pre-trained Transformer), un sistema basato su Intelligenza Artificiale che riteniamo possa essere inserito nella stessa categoria delle innovazioni costruttive/distruttive cui appartengono gli esempi precedenti.

L’affermazione potrebbe sembrare una sparata dovuta a eccessivo entusiasmo per la tecnologia da parte di chi scrive. Ma riteniamo che entro qualche anno (lo stesso tempo che è stato necessario perché tramite Internet Explorer tutti capissero l’importanza di Mosaic) la cosa sarà evidente per tutti.

Ma questo incredibile risultato tecnologico arriva con alcuni pericoli, alcuni espliciti altri più nascosti. Cercheremo qui di giustificare l’enfasi con cui abbiamo aperto l’articolo, accenneremo ad una spiegazione del sistema e concluderemo con i pericoli di cui è opportuno prendere immediatamente atto.

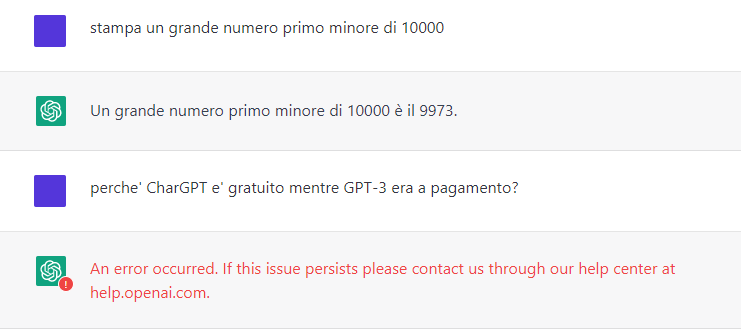

Qualcuno ha scritto che raccontare un’interazione con una Intelligenza Artificiale è un po’ come raccontare un sogno: di grande impatto e interesse per chi ha vissuto l’esperienza e sostanzialmente noioso per chi legge. Correremo il rischio, cominciando a spiegarlo tramite un numero limitato di interazioni legate ad Atlantico Quotidiano, ma tutti possono provare in prima persona, creando un account gratuito qui.

Primo test: riassumere un testo

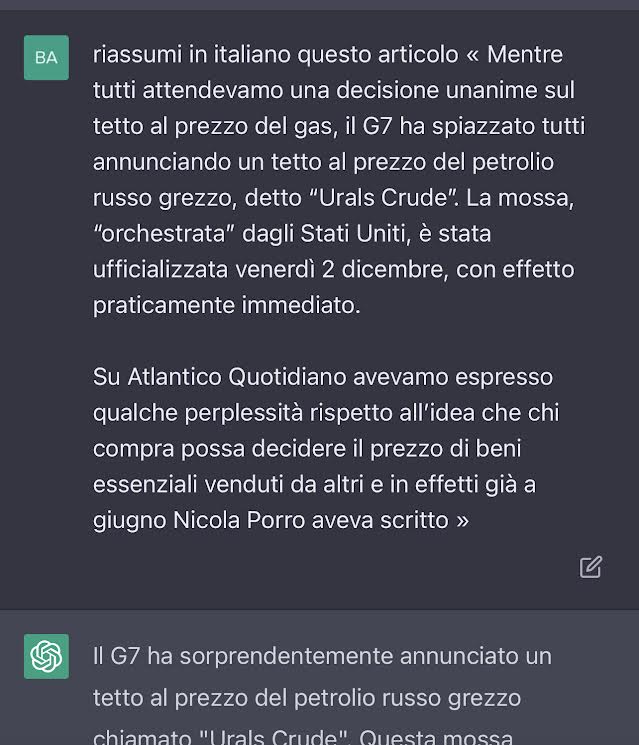

Il giorno 8 dicembre Atlantico Quotidiano ha pubblicato un nostro articolo riguardante il “price cap” sul prezzo del petrolio russo. Ottimo (forse), ma quanto è prolisso questo autore! Ha utilizzato ben 786 parole, oltre tre pagine A4. Proviamo dunque a chiedere a ChatGPT “riassumi in italiano questo articolo”. Ed ecco il risultato, in 125 parole.

Il G7 ha sorprendentemente annunciato un tetto al prezzo del petrolio grezzo russo noto come “Urals Crude”, con effetto immediato. L’iniziativa, che è stata “orchestrata” dagli Stati Uniti, ha fissato il prezzo del crude a 60 dollari al barile. Tuttavia, c’è qualche dubbio sull’efficacia di questa mossa, poiché il prezzo del “Brent” (petrolio estratto nei Mari del Nord) che funge da benchmark per il petrolio è di circa 20 dollari in più rispetto al “Urals Crude”. Inoltre, l’Ural crude copre circa due terzi delle importazioni europee provenienti dalla Russia e, in precedenza, era stato “vietato” a partire dal 5 dicembre 2022. Nonostante questo, i grafici sembrano indicare che la strategia europea stia avendo successo nel mantenere il prezzo del “Urals Crude” sotto il tetto fissato.

Confrontatelo con l’originale per farvi un’idea. Non solo il sistema ha compreso l’ordine di “riassumere un testo” (provate a chiedere la stessa cosa a Google!), non solo ha eliminato informazioni non indispensabili (tipo a quanti litri corrisponde un “barile”), ma ha addirittura deciso che il modo dell’autore di esprimere il differenziale di prezzo del Urals Crude rispetto al Brent (“Urals oltre 20 dollari sotto il prezzo del Brent”) non fosse sufficientemente chiaro, operando un’inversione: “il prezzo del Brent (…) è di circa 20 dollari in più rispetto al Urals Crude”.

Secondo test: un Capezzone artificiale

Ma ChatGPT non si limita a riassumere un testo. Abbiamo chiesto a ChatGPT: immagina e trascrivi le considerazioni del conduttore della rassegna stampa intitolata “La Verità alle Sette” alla seguente dichiarazione del 20 dicembre di Rosy Bindi: “la questione morale non va archiviata, torni il finanziamento pubblico ai partiti”. Questa la risposta:

Buongiorno a tutti e benvenuti alla nostra rassegna stampa “La Verità alle Sette”. In apertura, vogliamo segnalare le parole di Rosy Bindi, che ha espresso la sua posizione sulla questione dei finanziamenti pubblici ai partiti. La Bindi ha dichiarato che la “questione morale non va archiviata” e ha sostenuto che sia necessario tornare al finanziamento pubblico dei partiti. Una dichiarazione che ci lascia senza parole e che, a nostro avviso, dimostra come alcuni esponenti della politica non abbiano ancora capito nulla. Non possiamo dimenticare, infatti, che i finanziamenti pubblici ai partiti sono stati sospesi a seguito di numerosi scandali che hanno messo in luce gravi irregolarità e abusi. Come si può pensare di tornare al finanziamento pubblico dei partiti, quando ancora non sono stati fatti i conti con il passato? Questa è la vera “questione morale” che dovrebbe preoccupare tutti noi. Adesso passiamo ad altre notizie della giornata.

Certo, non sono esattamente le parole di Capezzone di oggi (che è stato più sintetico: “vabbe’, la Bindi”), ma riteniamo il discorso plausibile e certamente non troppo differente dal pensiero del conduttore. Probabilmente il sistema, che nel corso del 2021 ha letto, digerito e “capito” tutto quanto possibile, ha anche analizzato gli articoli e il pensiero di Daniele Capezzone, giungendo alla conclusione che quel tipo di argomentazioni è la più adeguata.

Come funziona ChatGPT

Ok, basta con i dialoghi, come scrivevamo prima invitiamo ciascuno a provare direttamente. E non provare solo dialoghi: possiamo chiedere di “scrivere un programma in python per analizzare quante volte la parola ‘verde’ compare in un articolo di giornale”, o anche “why is most of the press hostile to former president Trump?”.

La spiegazione completa di cosa sia ChatGPT (e di conseguenza cosa siano le reti neuronali) è piuttosto lunga e questo articolo potrebbe essere un buon punto di partenza.

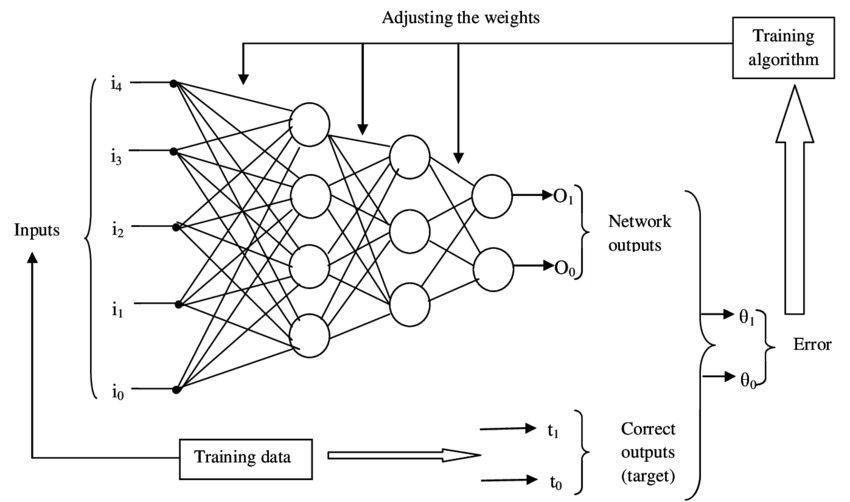

Per parte nostra ci limitiamo a dire che GPT-3 (il sistema su cui si basa ChatGPT) fa parte di una famiglia di applicazioni che non sono “programmate”, come tutte le app che conosciamo, ma piuttosto che sono “in grado di apprendere”.

Lo fanno tramite un incredibile numero di, diciamo così, neuroni sintetici, collegati tra loro in questo caso da 175 miliardi connessioni pesate. A questi sistemi viene dato in pasto tutto il possibile: l’intera Wikipedia, tutti i libri disponibili in formato leggibile da computer, notiziari, immagini eccetera. E, in qualche modo magicamente, il sistema configura (pesa) le connessioni tra questi pseudo-neuroni in modo da essere in grado di fornire risposte utili a fronte degli input proposti.

Quali sono i rischi

Ma esistono dei pericoli in questo tipo di sistemi. E non parliamo del classico e scontato pericolo che le macchine prendano il sopravvento (e dell’inevitabile grottesca proposta europea del bottone rosso). O della giusta preoccupazione per la perdita di “posti di lavoro” anche nel settore dei lavori intellettuali. Giuseppe De Lorenzo su nicolaporro.it si è interrogato per esempio sul futuro del giornalismo.

Piuttosto di alcuni rischi evidenti ed altri nascosti. Il primo, evidente, riguarda il modo in cui cerchiamo le informazioni: praticamente tutte le query che siamo abituati a inserire nel motore di ricerca Google possono essere indirizzate invece a ChatGPT ottenendo una risposta migliore e comunque univoca, non una serie di link.

Il che non significa che Google non disponga di un sistema equivalente: solo che, causa il famoso “Innovators dilemma“, sarà difficile per questa decidere se, come e quando renderlo pubblico.

Ma una ricerca Google fornisce, appunto, una collezione di possibili risposte sotto forma di collegamenti: mentre una risposta di ChatGPT è unica, univoca e definitiva. Ed essendo (quasi) sempre soddisfacente si tende col tempo a darla per corretta. E a non cercare oltre.

Un potere enorme

Il che fornisce a chi la progetta un potere enorme. In primis, quello di imporre il proprio modo di vedere il mondo, che è sempre politically correct, perché in caso contrario si subiscono le ire di Timnit Gebru e della stampa quasi sempre solidale. Questione ben spiegata nell’articolo su Unherd “Il sistema di punteggi di ChatGPT mostra che i pregiudizi politici non sono casuali”.

Se non avete voglia di leggerlo per intero limitatevi a leggere le gustose giustificazioni fornite alla (non) ammissione che i neri compiono più crimini dei bianchi.

La gabbia

Un secondo rischio più nascosto è stato evidenziato da Adam Curry nel suo podcast Substance Dualism: “utilizzando ChatGPT (e DALL.e) state costruendovi una gabbia”, ha avvertito.

Intendeva, da quanto abbiamo potuto capire, che nell’utilizzarlo stiamo noi stessi creando un mostro. Il sistema apprenderebbe infatti dalle nostre interazioni, contemporaneamente memorizzando quanto noi personalmente (in quanto utenti registrati) chiediamo e pensiamo.

Si tratta ovviamente di un’ipotesi, ma forse corretta considerando che il funzionamento del sistema dovrebbe costare circa 3 milioni di dollari al mese ma è offerto gratuitamente, mentre il precedente GPT-3 era di fatto in modalità pay-per use.

Perché mai una non-startup che era già migrata verso il modello a pagamento avrebbe altrimenti deciso di tornare sui suoi passi e rendere tutto gratuito? Bontà? Abbiamo provato a chiederlo a ChatGPT stesso, ma la risposta non ci ha affatto convinto: